[Novos Dados] A Inteligência Artificial traz mais tráfego do que conteúdo humano?

Desde o boom da Inteligência Artificial, muito se questiona o seu impacto na qualidade das pesquisas, do conteúdo entr(...)

Desde o boom da Inteligência Artificial, muito se questiona o seu impacto na qualidade das pesquisas, do conteúdo entr(...)

Simplifique com AI Content Wizard.

As redes sociais estão explorando o potencial da inteligência artificial para revolucionar a forma como o conteúdo é(...)

Desde o boom da Inteligência Artificial, muito se questiona o seu impacto na qualidade das pesquisas, do conteúdo entr(...)

SEO para TikTok é o conjunto de estratégias de Otimização para Mecanismo de Busca (SEO) voltadas para aumentar o alc(...)

Acesse, em primeira mão, nossos principais posts diretamente em seu email

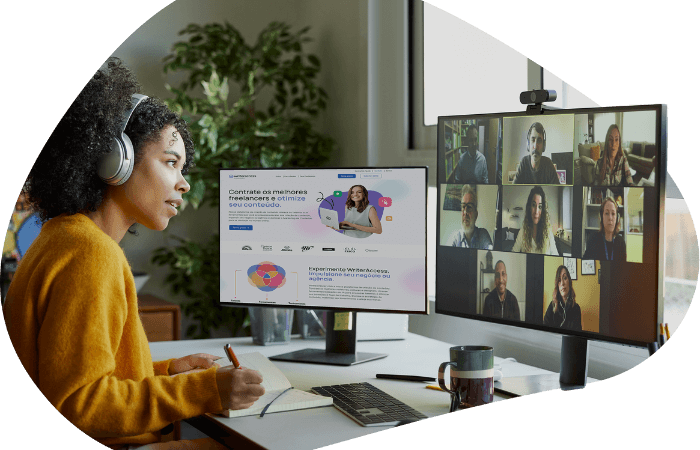

Tenha acesso a mais de 15.000 freelancers especializados em redação, edição, tradução, design e muito mais, prontos para serem contratados.